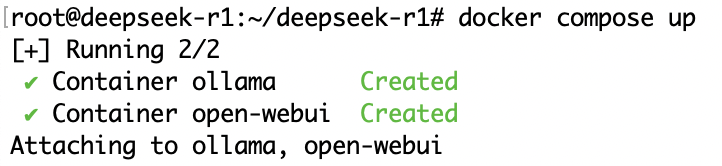

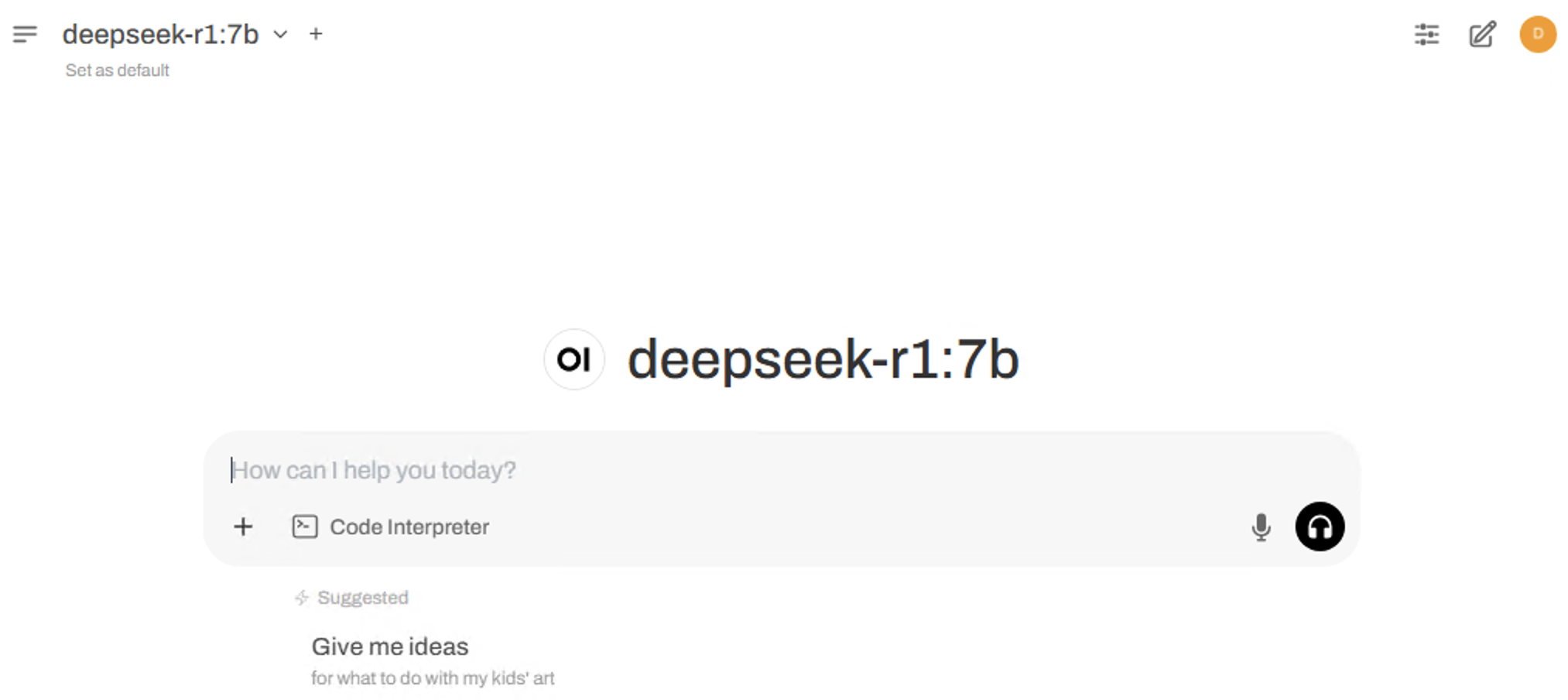

【教程】阿里云服务器本地部署 DeepSeek R1 时间: 2025-02-25 16:41 分类: 猿码 热度: 256°C 评论 本教程教大家如何使用阿里云 GPU 实例 ECS 基于 Ollama + Open WebUI 部署 DeepSeek R1 模型的过程。 ##准备材料 ####阿里云服务器传送门:https://iil.ink/aliyungpu 选用的是阿里云 GPU 计算型 T4 加速型 ECS ,实例规格:ecs.gn7i-c8g1.2xlarge,CPU&内存:8核31G,GPU:NVIDIA T4,GPU显存:16G,操作系统:Ubuntu 24.04。  ##安装步骤 1、###Ubuntu 安装 ollama curl -fsSL https://ollama.ai/install.sh | sh 在安装过程中下面这个阶段停留时间比较长 Loading new nvidia-570.86.15 DKMS files... Building for 6.8.0-51-generic Building for architecture x86_64 Building initial module for 6.8.0-51-generic EFI variables are not supported on this system /sys/firmware/efi/efivars not found, aborting. 安装完成时的控制台输出 >>> NVIDIA GPU ready. >>> The Ollama API is now available at 127.0.0.1:11434. >>> Install complete. Run "ollama" from the command line. curl 命令访问 11434 端口 curl 127.0.0.1:11434 得到下面的响应,说明 ollam 已正常运行 Ollama is running 我们这里部署 deepseek-r1 7b 模型,模型文件大小是4.7GB 拉取模型 ollama pull deepseek-r1:7b 如果拉取不下来,可以参考下面的方案。 > 服务器用cmd方式启动可以看到日志, 日志有提示如果下载不动就按ctrl+c, 我也遇到一样的问题, 按了好多次 我是自己用ollama run 方式下载的, 直接用默认地址, 按ctrl+c后再启动继续下 ollama 是0.5.7版本, 看是否版本太旧 如果还是不行,可以改为用 docker 拉取包含 deepseek-r1:7b 的 allama 镜像。 幸好 docker hub 上有现成的镜像 https://hub.docker.com/r/mazurkatarzyna/ollama-deepseek-r1-7b docker pull mazurkatarzyna/ollama-deepseek-r1-7b:latest 然后用 docker compose 进行部署,docker compose 清单文件如下: services: ollama: container_name: ollama pull_policy: if_not_present image: mazurkatarzyna/ollama-deepseek-r1-7b:latest deploy: resources: reservations: devices: - driver: nvidia count: 1 capabilities: - gpu environment: OLLAMA_ORIGINS: "*" OLLAMA_HOST: "0.0.0.0" open-webui: image: ghcr.io/open-webui/open-webui:ollama container_name: open-webui volumes: - open-webui:/app/backend/data depends_on: - ollama ports: - 8080:8080 environment: - 'ENABLE_OPENAI_API=False' - 'OLLAMA_BASE_URL=http://ollama:11434' - 'WEBUI_SECRET_KEY=' extra_hosts: - host.docker.internal:host-gateway volumes: open-webui: {} docker compose 部署时出现下面的错误 Error response from daemon: could not select device driver "nvidia" with capabilities: [[gpu]] 需要通过下面的命令安装 NVIDIA Container Toolkit curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey \ | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list \ | sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' \ | sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list sudo apt-get update sudo apt-get install -y nvidia-container-toolkit sudo nvidia-ctk runtime configure --runtime=docker sudo systemctl restart docker 安装之后 docker compose 部署成功,ollama 与 Open WebUI 容器成功启动。  通过 IP 地址访问服务器的 8080 端口就会看到 Open WebUI 的界面,创建账号后登录,就会看到默认选中了 deepseek-r1:7b ,并且可以进行对话了。  出现上述界面,就已经搞定了。 ##扩展阅读: [【教程】本地部署 DeepSeek](https://blog.gaomeluo.com/archives/bushuDeepSeek/ "【教程】本地部署 DeepSeek") [【教程】怎么在Mac(以及iPhone)本地跑DeepSeek R1?](https://blog.gaomeluo.com/archives/bushuDeepSeek-mac/ "【教程】怎么在Mac(以及iPhone)本地跑DeepSeek R1?") [如何给本地部署的DeepSeek投喂数据?](https://blog.gaomeluo.com/archives/touweiDeepSeek/ "如何给本地部署的DeepSeek投喂数据?") [把DeepSeek部署到到WPS上,实现AI赋能](https://blog.gaomeluo.com/archives/DeepSeekWPS/ "把DeepSeek部署到到WPS上,实现AI赋能") 标签: 服务器 AI智能

评论已关闭