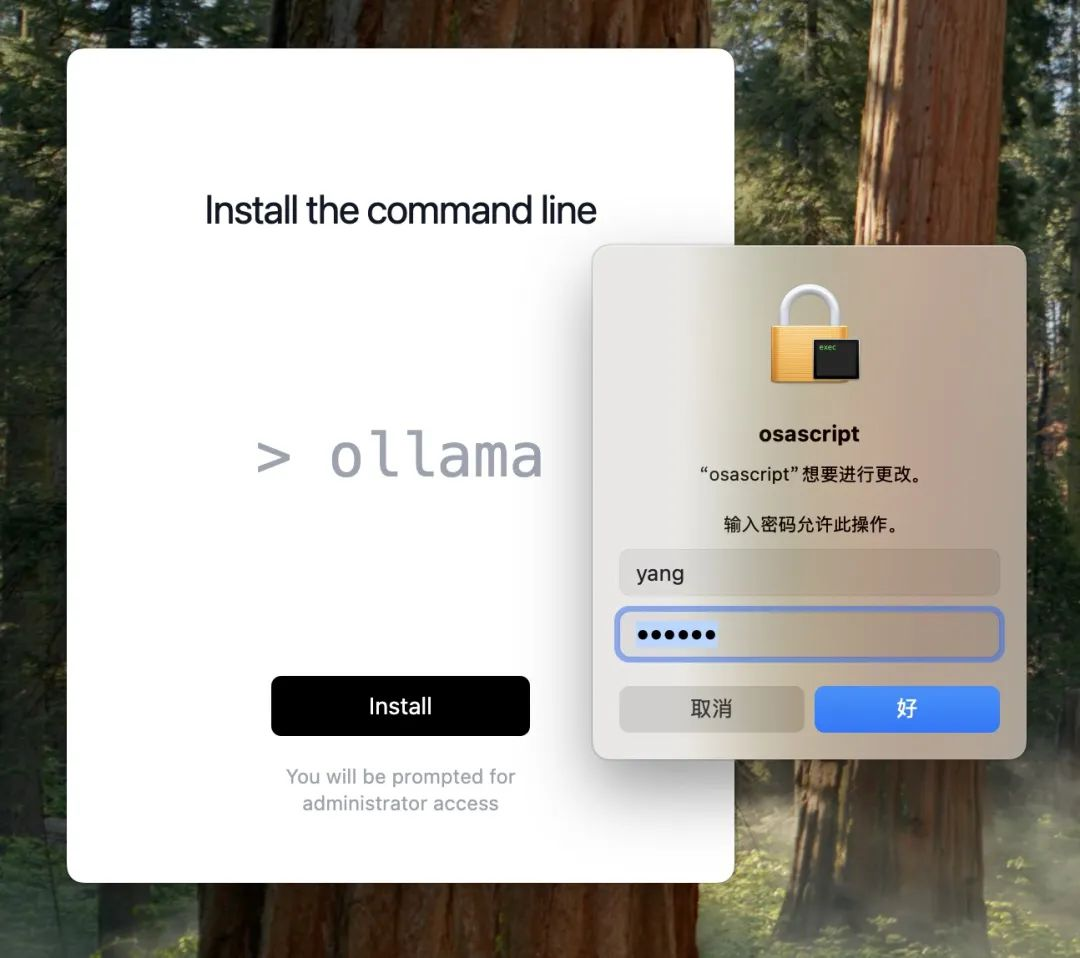

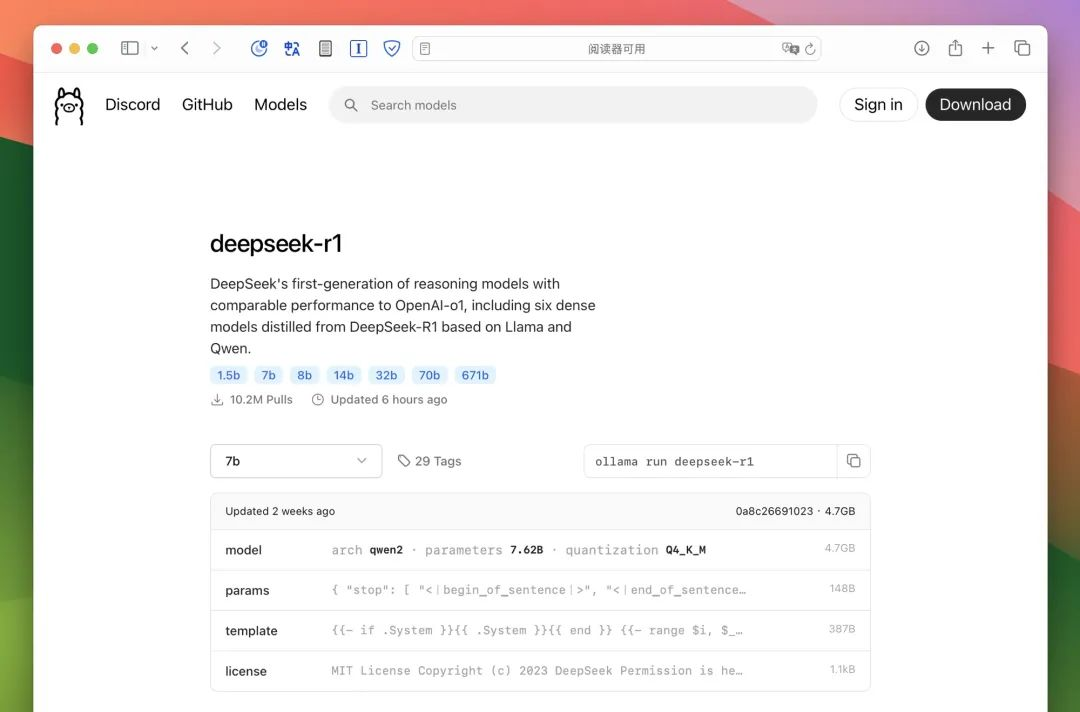

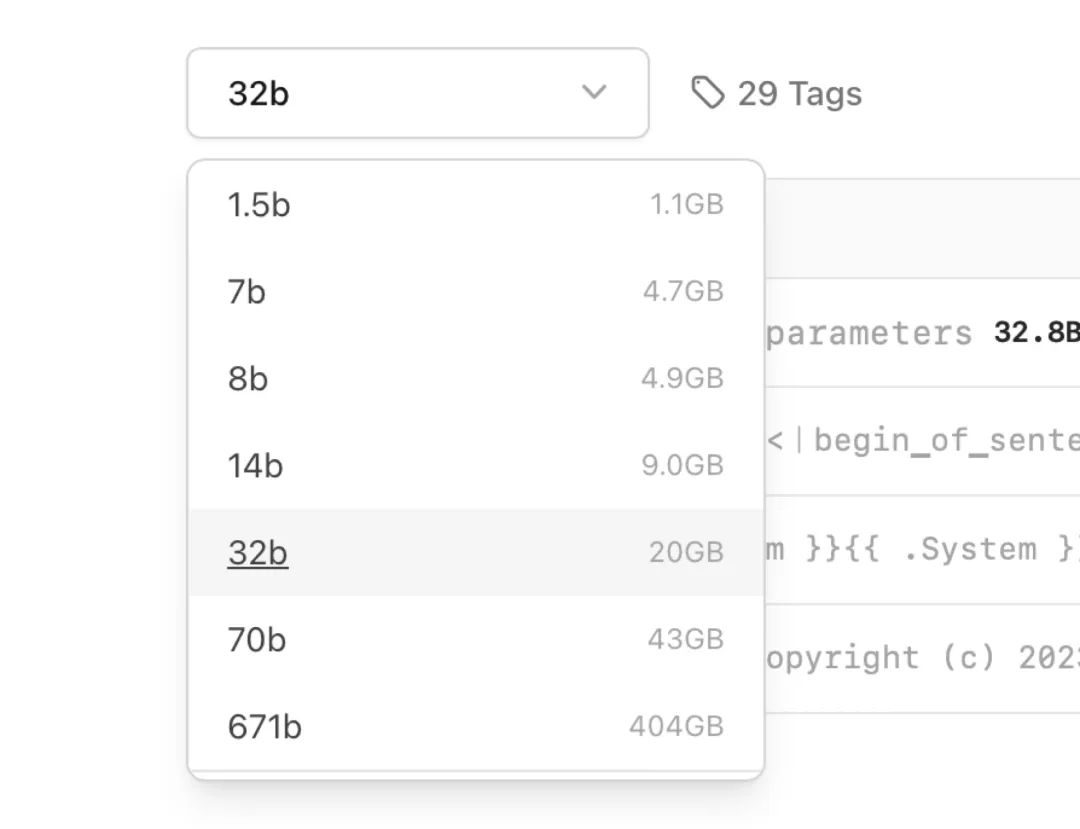

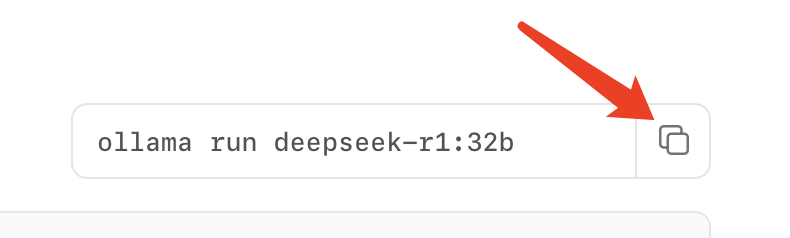

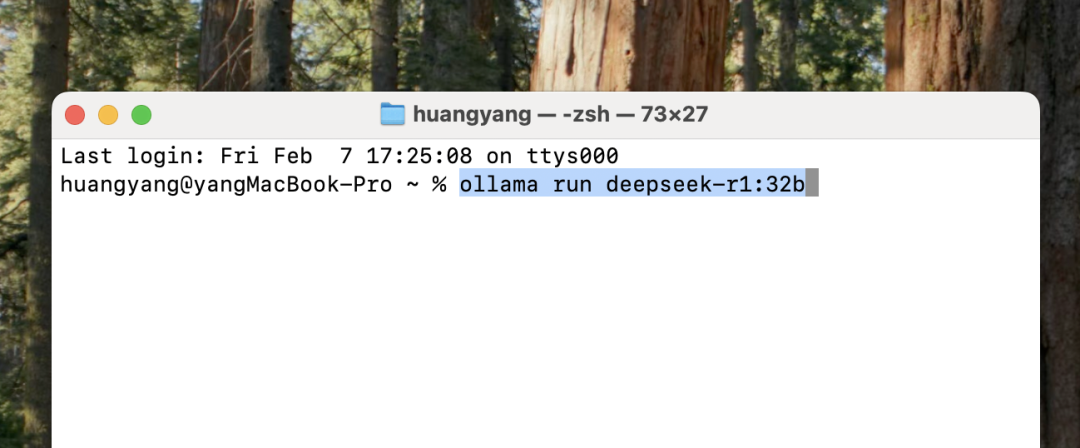

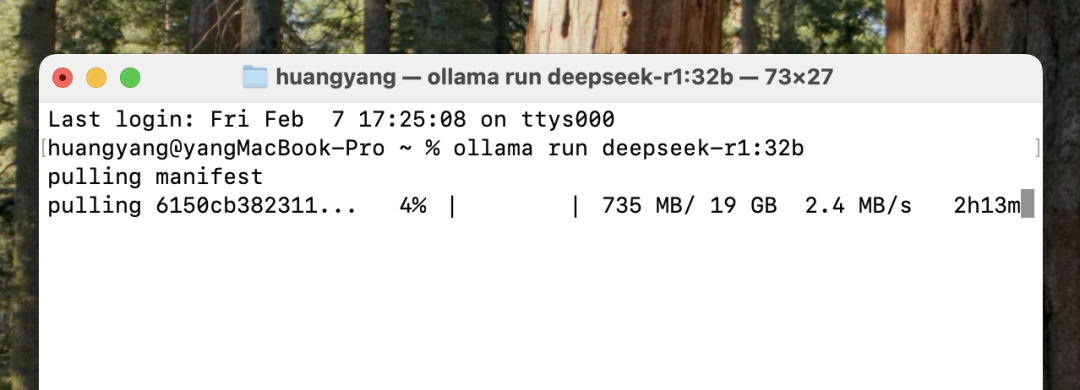

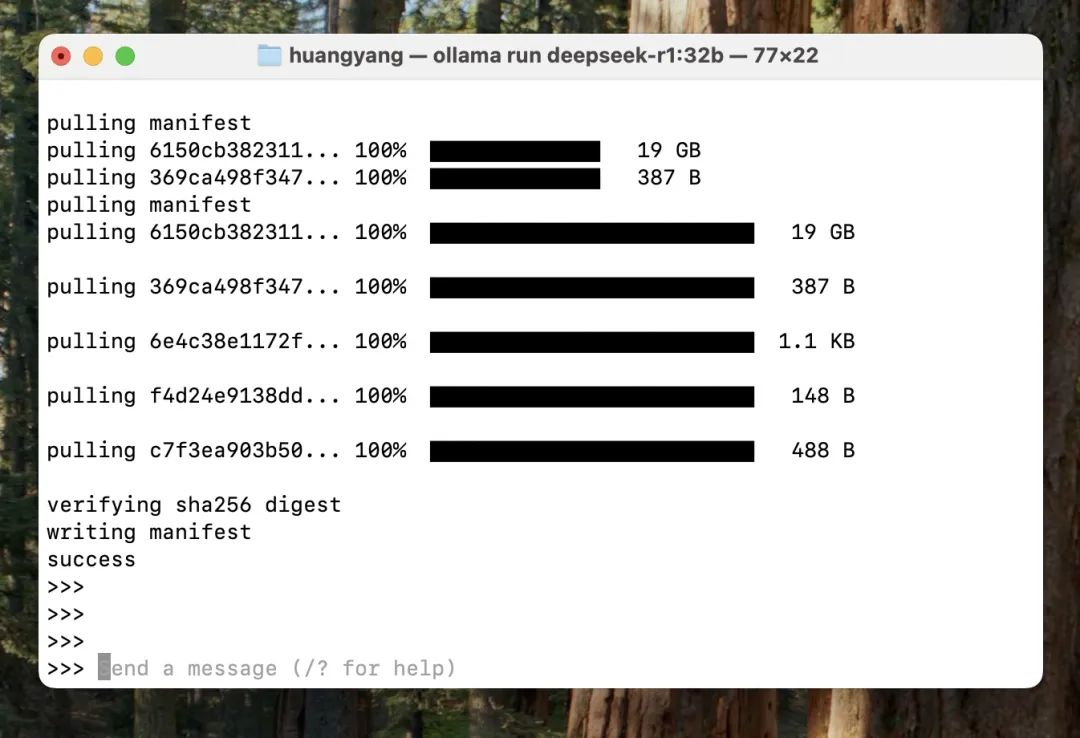

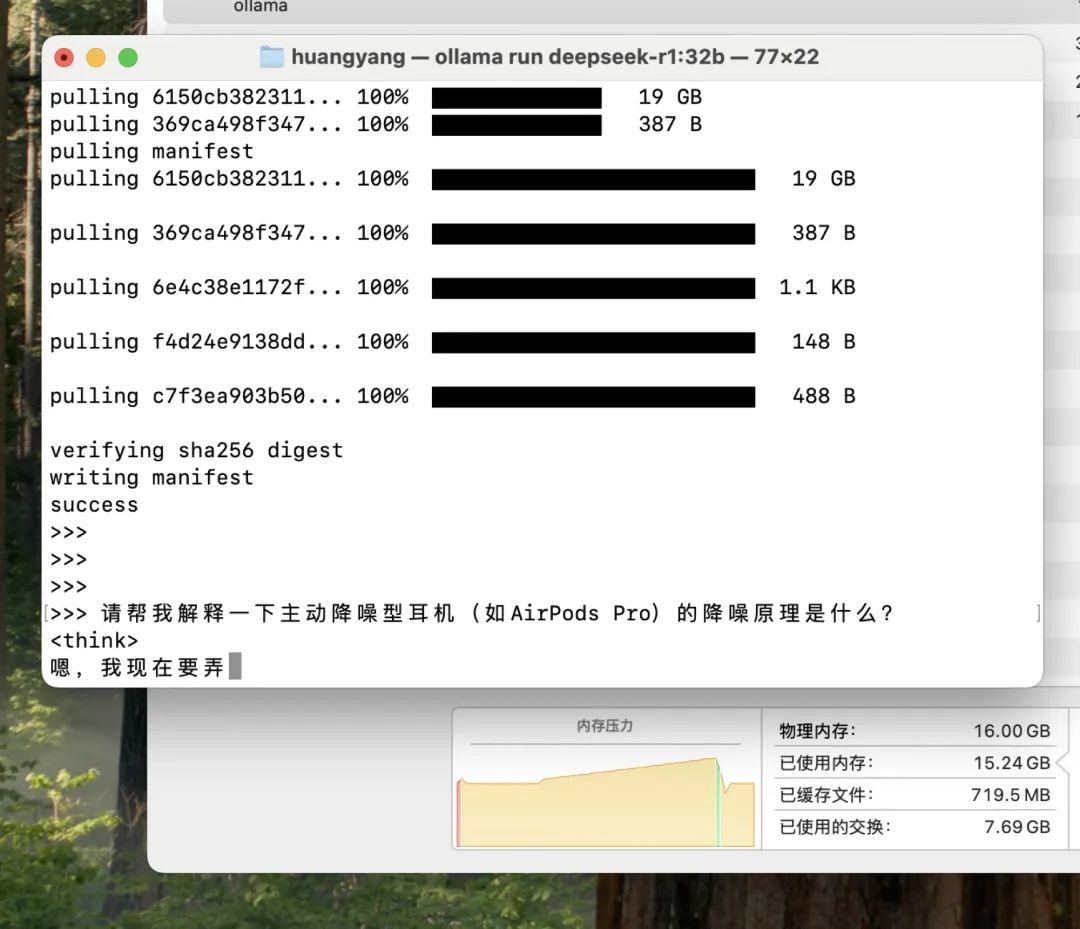

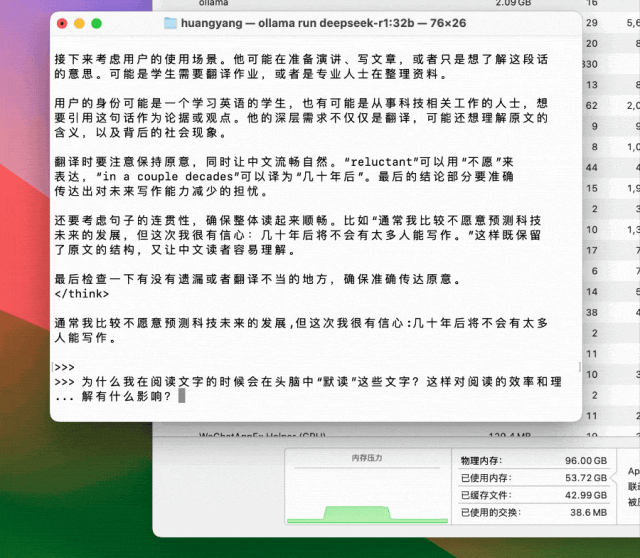

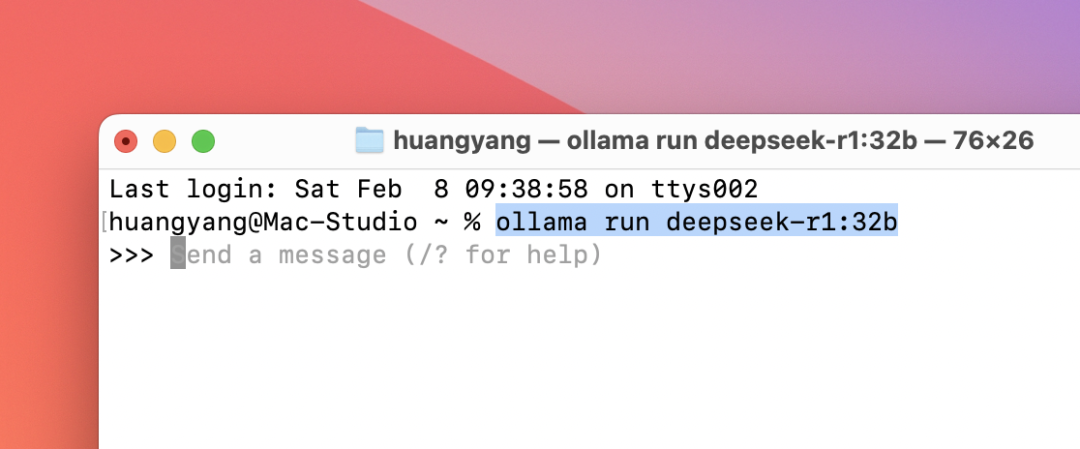

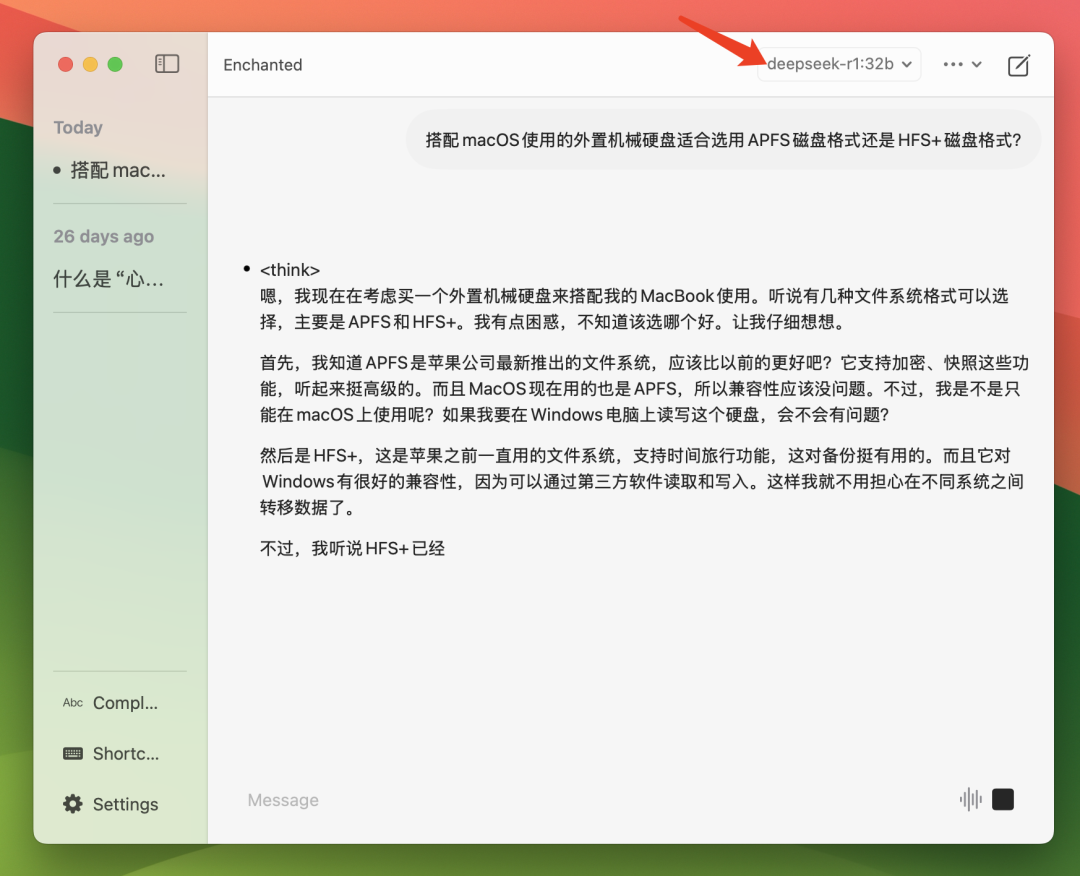

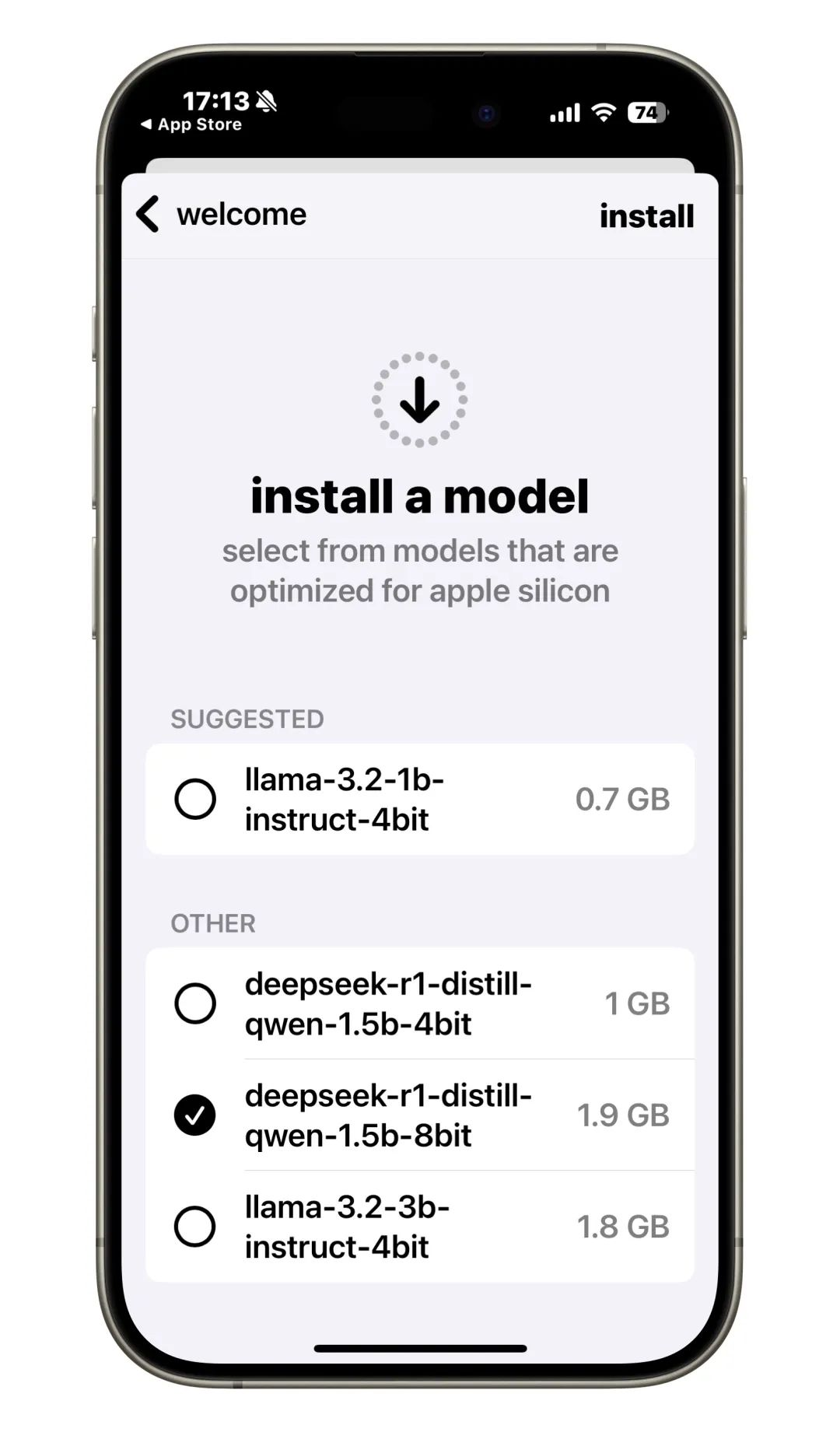

【教程】怎么在Mac(以及iPhone)本地跑DeepSeek R1? 时间: 2025-02-15 11:24 分类: 猿码 热度: 283°C 评论 在上一篇文章中,我们说了怎么在本地部署DeepSeek。是在win环境下,对本地部署DeepSeek感兴趣的小伙伴看过来。 #####传送门:[【教程】本地部署 DeepSeek](https://blog.gaomeluo.com/archives/bushuDeepSeek/ "【教程】本地部署 DeepSeek") 本教程教大家怎么在Mac(以及iPhone)本地跑DeepSeek R1。 个人觉得,目前阶段在普通电脑本地跑大模型,折腾乐趣大于实用价值。写这篇文章是想帮助想要尝试在 Mac 本地跑的朋友尽快跑起来,不要浪费更多时间,以及金钱(下面的方案完全免费)。 ###安装 Ollama 第一步安装 Ollama,打开官网 ollama.com,点 Download,选择 macOS 版下载即可。把下载的 zip 包解压,并把 Ollama.app 文件放到访达「应用程序」文件夹。  第一次打开 Ollama,点黑色 Install 按钮,然后输入你的 Mac 用户密码授权就可以关闭 Ollama 窗口了。  Ollama 没有用户界面。在安装和使用本地大模型时,需要保持 Ollama 在后台开启(在 macOS 菜单栏能看到 Ollama 图标)。  ###安装 DeepSeep R1 接下来是安装 deepseek-r1,打开 https://ollama.com/library/deepseek-r1 。  选择想要跑的蒸馏模型(Distilled models),比如 7b、32b,后面会显示这个模型的大小。模型越大,表现越好,但对电脑的性能(尤其是大内存)的要求也越高,总之丰俭由人。  我想先在我这台 MacBook Pro M4 16GB 上试试 32b 蒸馏模型(事实证明不太能跑起来),直接复制 32b 后面的安装命令。  然后打开「终端」,粘贴命令并回车。  接下来就是等待这个模型下载完成,不需要特殊网络。  显示 success 就表示这个本地大模型下载完成了,直接输入文本和它对话了。  我这台 MacBook Pro 跑起来相当吃力,一分钟蹦不出来俩字,内存爆表,可以说 32b 在我这台 M4 16GB 笔记本上完全没法跑。  我还有一台配置不错的 Mac Studio,M2 Max 芯片 96GB 内存,同样是 r1:32b 的蒸馏模型,只等个三、五秒就开始噌噌吐文字,跟线上版速度体验差不多。  一直觉得自己用这台 Mac Studio 性能过剩了,这下不就用上了。 按 control + D 就可以结束对话,下次开启对话就打开终端输入 ollama run deepseek-r1:32b。  ###想要用户界面 如果你不喜欢通过终端使用,也可以安装 Enchanted 这个免费 Mac 软件(在 App Store 直接下载),它相当于给 Ollama 套了个壳(GUI)。  然后就可以跟使用网页版或 App 一样开启对话了。如果你同时安装了多个不同的本地模型,也可以切换使用。  使用 Enchanted 时也要确保 Ollama 在后台运行。 ###在 iPhone/iPad 上跑 DeepSeek R1 本地模型 在 iPhone 和 iPad 本地安装和使用 DeepSeek R1 也很简单,先在 App Store(国区也可)下载「fullmoon」这款免费 App。  下载好打开,就会先提示你安装第一个本地大模型,不过只有 1.5b 的两个蒸馏,更大了手机怕是也跑不动。选 1.9GB 的那个 deepseed-r1-1.5b-8bit 并点右上角 install 来下载。  下载过程可能需要开特殊网络。 这里推荐我一直在用2年没跑路的梯子(流量多、节点多、速度快、稳定便宜),参考下面这篇文章: **《[魔戒VPN——节点多、速度快、稳定,推荐!!!](https://inurl.top/archives/mojie/ "魔戒VPN——节点多、速度快、稳定,推荐!!!")》 《[中国国际机场VPN——节点多、流量多 、稳定 ,推荐!!!](https://inurl.top/archives/zhongguuojichangvpn/ "中国国际机场VPN——节点多、流量多 、稳定 ,推荐!!!")》**  下载好就可以跟 DeepSeek R1 对话啦!我这台 iPhone 15 Pro 上速度很快。  是不是很简单? ###扩展阅读: ####【[如何给本地部署的DeepSeek投喂数据?](https://blog.gaomeluo.com/archives/touweiDeepSeek/ "如何给本地部署的DeepSeek投喂数据?")】 ####【[把DeepSeek部署到到WPS上,实现AI赋能](https://blog.gaomeluo.com/archives/DeepSeekWPS/ "把DeepSeek部署到到WPS上,实现AI赋能")】 标签: AI智能

评论已关闭